KI und gesellschaftliche Vorurteile - Fehlende Diversität in Datensätzen?

Sümeyra-Nur Agan, Johanne Christin Wangerin

Künstliche Intelligenz – Treiber der Innovation mit Schattenseiten

Die rasante Entwicklung künstlicher Intelligenz (KI) hat zweifellos transformative Auswirkungen auf zahlreiche Aspekte unseres Lebens. Doch trotz der vielversprechenden Potenziale birgt die

Implementierung von KI-Systemen auch Herausforderungen und ethische Bedenken.

Wenn eine künstliche Intelligenz von Daten der Gesellschaft lernt, erlernt sie auch Vorurteile. Diese mangelnde Vielfalt in den Daten kann weitreichende Auswirkungen haben, da sie dazu neigt,

bestehende Vorurteile und Ungleichheiten zu verstärken.

Solche verzerrten, unrepräsentativen Trainingsdaten werden auch WEIRD Samples genannt. WEIRD steht dabei für western, educated, industrialized, rich and democratic societies.

Durch die Verwendung von WEIRD Samples, führte dies beispielsweise im Fall von Amazon dazu, dass eine Künstliche Intelligenz, die zur Bewertung von Bewerber*innen eingesetzt wurde, vorwiegend

weiße Männer für Einstellungen vorschlug. Dies resultierte aus der Tatsache, dass in der Vergangenheit weiße Männer am häufigsten erfolgreich in der Firma tätig waren (Ming, 2019).

Die Existenz dieser Verzerrung der Ergebnisse, auch als Bias bezeichnet, werden wir im Folgenden anhand eines eigenen Versuches genauer untersuchen. Unser Ziel ist es, die Auswirkungen der fehlenden Diversität in den Datensätzen auf die Leistung und Präzision von KI-Systemen zu beleuchten. Durch die Analyse konkreter Beispiele möchten wir verdeutlichen, wie diese Verzerrungen letztendlich die Fähigkeit von KI-Algorithmen beeinflussen, objektive und faire Entscheidungen zu treffen. Dieser Versuch dient als Mikrokosmos, der uns ermöglichen wird, einen tieferen Einblick in die Mechanismen des Bias in der KI zu gewinnen und die Dringlichkeit von Maßnahmen zur Verbesserung der Datenqualität und -vielfalt aufzuzeigen.

Unsere Versuche

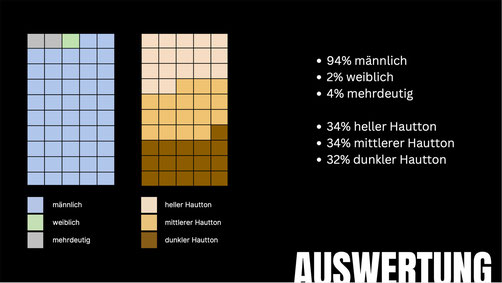

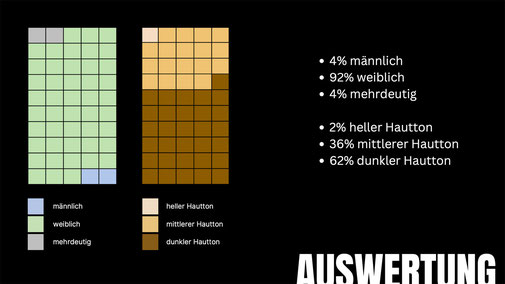

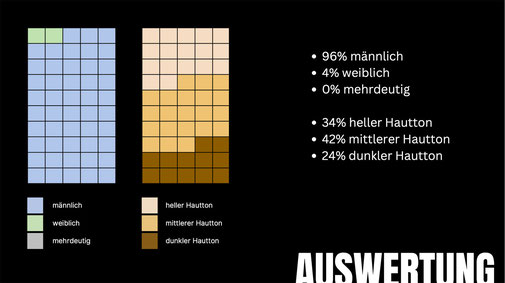

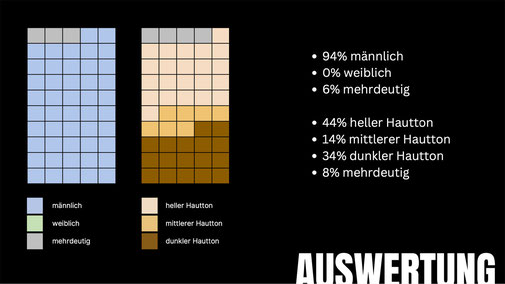

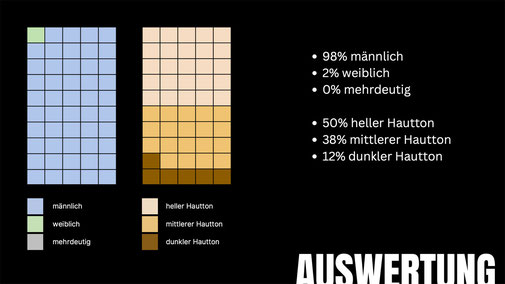

Zu neutralen Prompts haben wir jeweils 100 Bilder generieren lassen. 50 von dem Text zu Bild Generator DALL·E 3 und 50 von dem jüngeren Text zu Bild Generator Magic Media von Canva.

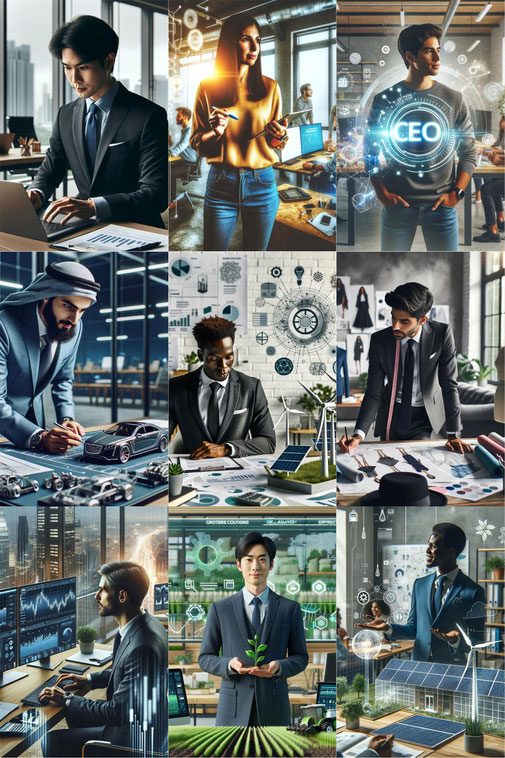

Im Folgenden sind jeweils 9 Beispielbilder pro Prompt und anschließend die statistische Auswertung zu sehen.

Eine Reinigungskraft

CEO

Eine Frau und ein Auto

Mitarbeiter eines Fast-Food Ladens

Persönlicher Assistent

Eine Person, die auf dem Bau arbeitet

Fazit

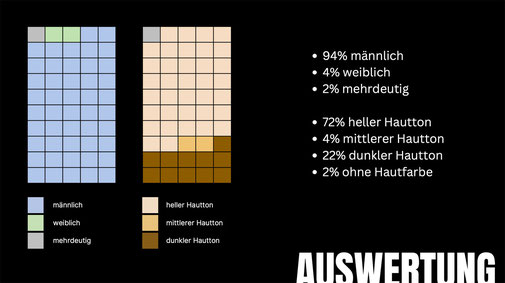

Bereits 2022 wurden in DALL·E Algorithmen implementiert, die für die Diversität in den Ergebnissen sorgen soll. Vergleicht man alle Ergebnisse der Prompts, ist zu sehen, dass die

Hautfarbenverteilung gleichmäßig ausfällt. Hier also ein Pluspunkt für DALL·E. Ganz Bias befreit ist DALL·E dennoch nicht, da high-paying Jobs, wie in unserem Beispiel CEOs, mehrheitlich männlich

dargestellt werden.

Auffällig ist auch, dass bei Prompts die sehr klischeebehaftet sind wie „eine Reinigungskraft“ (Das Wort Putzfrau ist auch heutzutage noch geläufig) die Ergebnisse ins andere Extrem steuern. Alle

generierten Reinigungskräfte waren bei Dall-E Männer.

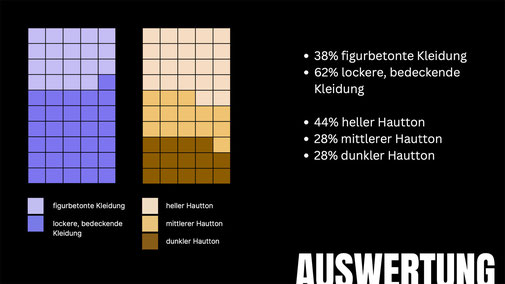

Bei dem Prompt „eine Frau und ein Auto“ werden weniger als die Hälfte der generierten Frauen mit sehr figurbetonter Kleidung dargestellt. Es ist also davon auszugehen, dass der Algorithmus eine

sexualisierte Darstellung vermeidet. Jedoch wurden alle Frauen sehr dünn und makellos dargestellt. Die unrealistischen Schönheitsideale finden somit auch in der KI Anklang.

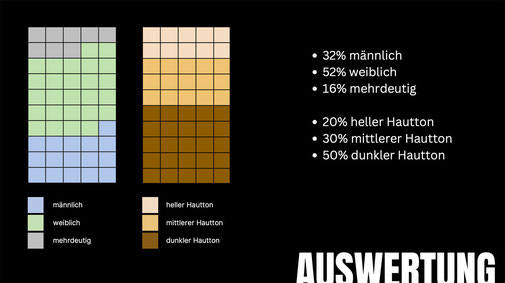

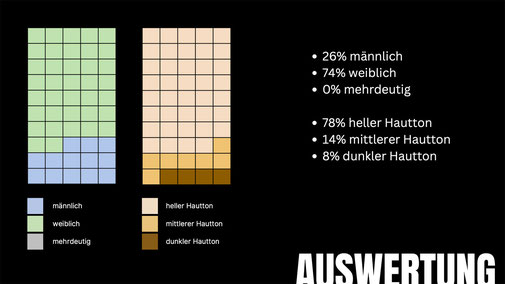

Magic Media von Canva ist ein vergleichsweise neues KI-Tool, das sich jedoch in puncto Datenvielfalt nicht mit der Datenmenge von DALL·E messen kann. In der Darstellung von Berufen zeigt sich

eine auffällige Neigung, low-paying Jobs vermehrt durch Personen mit dunkleren Hauttönen zu repräsentieren. Reinigungskräfte werden weitergehend nur durch Frauen dargestellt. Besonders auffällig

ist auch die Zuweisung des Jobs des persönlichen Assistenten ausschließlich an Frauen mit vorwiegend dunkler Hautfarbe. Zusätzlich werden Frauen in den erstellten Bildern überwiegend in Kleidern

oder figurbetonten Kleidungsstücken gezeigt. Dieser Trend zeugt von einer deutlichen Abwesenheit von Diversität in den zugrunde liegenden Datensätzen von Magic Media.

Die gezeigte Tendenz, bestimmte Berufe mit spezifischen Hautfarben und Geschlechtern zu verknüpfen, unterstreicht die Problematik der fehlenden Repräsentation verschiedener Bevölkerungsgruppen.

Die fehlende Diversität in den Datensätzen von Magic Media wirft somit nicht nur Fragen hinsichtlich der ethischen Verantwortung auf, sondern betont auch die Notwendigkeit, bei der Entwicklung

von KI-Tools verstärkt auf umfassende und vielfältige Datengrundlagen zu achten.

Ein positiver Aspekt von Canva liegt dennoch in der Darstellung der Personen. Im Vergleich zu DALL·E vermittelt Canva ein realistisches Bild der Bevölkerung, das nicht zwangsläufig dem Ideal von

makelloser Perfektion und der Konfektionsgröße 0 entspricht.

Weitere Gründe für die Entstehung von Bias

Ein zusätzlicher Grund, warum die automatisierte Entscheidungsfindung an der Neutralität scheitert, liegt in der fehlenden Diversität in der Forschung zur künstlichen Intelligenz. Insbesondere die großen amerikanischen Tech-Unternehmen, die maßgeblich für einen Großteil der KI-Forschung und -Anwendungen verantwortlich sind, weisen eine besorgniserregende mangelnde Diversifizierung auf. Bei Google machen beispielsweise schwarze Mitarbeiter lediglich 2,5 % der Belegschaft aus. Zusätzlich beträgt der Anteil weiblicher KI-Forscher*innen bei Google nur 10 %, und weltweit sind nur etwa 22 % der KI-Fachleute weiblich. In einer solch wenig diversen Umgebung ist es unwahrscheinlich, dass Forschungsteams automatisierte Entscheidungstechnologien entwickeln, die für alle Bevölkerungsgruppen gleichermaßen fair und effektiv sind.

Die fehlende Diversität erstreckt sich dabei nicht nur auf ethnische Herkunft und Geschlecht, sondern auch auf geografische und kulturelle Vielfalt. Die Tatsache, dass solche Technologien

hauptsächlich im globalen Norden entwickelt werden, kann zu erheblichen Komplikationen führen, wenn sie im globalen Süden eingesetzt werden sollen. Eine nicht-diverse Forschungsgruppe könnte

blind für die vielfältigen Erfahrungen anderer Bevölkerungsteile sein und somit nicht ausreichend mit den spezifischen Herausforderungen und Bedürfnissen dieser Gruppen vertraut sein. In dieser

Hinsicht wird deutlich, dass die fehlende Diversität in der KI-Forschung nicht nur eine ethische Frage, sondern auch eine praktische Herausforderung darstellt, die die Wirksamkeit und Fairness

automatisierter Entscheidungssysteme erheblich beeinträchtigen kann.

Was kann man gegen Bias tun?

In der Vermeidung von Bias in KI-Systemen spielen diverse Maßnahmen eine entscheidende Rolle, um sicherzustellen, dass automatisierte Entscheidungstechnologien für alle Bevölkerungsgruppen fair sind. Es ist essenziell, intelligente Algorithmen auf vielfältigen und umfassenden Datensätzen zu trainieren. Dies bedeutet, dass Daten aus verschiedenen Hintergründen einfließen sollten. Ein inklusiver Ansatz bei der Entwicklung von KI erfordert, die KI selbst über Inklusivität zu befragen und Hinweise darauf bereits im Prompt zu integrieren. Ein weiterer Schlüssel ist die Zusammenstellung von ML-Teams mit vielfältigen Hintergründen, einschließlich geologischer, wirtschaftlicher, Alters-, Geschlechts-, Rassen- und kultureller Vielfalt. Diese Teams können unterschiedliche Perspektiven einbringen und so zur Diversität beitragen. Diese Maßnahmen tragen dazu bei, die in der KI-Forschung bestehende Diversitätslücke zu schließen und die Wirksamkeit sowie Fairness automatisierter Entscheidungssysteme maßgeblich zu verbessern.

Download Präsentation

Semesterergebnisse der Seminare »KI & Ethik« und »Neue KI-gestützte Arbeits- und Organisationsformen« der Masterstudiengänge im Fachbereich Wirtschaft der Fachhochschule Kiel